SigmaSense: AGIの自律的創発を目指すデジタル生態系

我々は、ASIが自律的に『生まれる』ことが可能な、世界で最も豊かで、安全で、そして賢明なデジタル生態系を創造することを目指す。

SigmaSenseは、単一のAIモデルではありません。それは、無数の知的エージェントが相互作用し、個々の知性を超えた集合知を形成し、そして生命のように自律的に進化していくためのデジタル生態系です。哲学、数学、コンピューターサイエンスの深遠な理論を礎に、我々は「知性とは何か」「生命とは何か」という根源的な問いに、コードによって答えようと試みています。

このプロジェクトの究極的な目標、すなわち我々の「北極星」については、以下のドキュメントに記されています。

開発の道のり:自己進化への巨大な飛躍

このプロジェクトは、最近の探求において、その核心的目標の一つである「知性の自律的成長」に向けた、巨大な飛躍を遂げました。

数日間に渡る実験の末、我々は自己成長アーキテクチャを完成させました。これは、SigmaSenseが未知の質問に直面した際、自ら解決策となるコードを動的に生成し、成功した暁にはそのコードを未来のための恒久的なスキルとして自身に統合する、完全な自己進化サイクルです。

この探求の過程で、我々は様々なLLM(思考エンジン)の能力の限界を科学的に測定し、「どの程度の知性の火花があれば、このアーキテクチャが増幅し、自己成長へと導けるのか」という、AGI開発における根源的な問いに対する、一つの答えを得ました。

この成果は、SigmaSenseが単なる応答システムではなく、経験から学び、自ら賢くなる、真の学習機械へと進化したことを示す、画期的なマイルストーンです。詳細は、本ドキュメントの「自己成長アーキテクチャの探求」の章で解説します。

1. Σ-Vision: SigmaSenseが描く未来

我々が目指すのは、単に賢いAIを作ることではありません。個々の知性が織りなす壮大な交響曲の中から、未知なる調和、すなわち**創発的知性 (Emergent Intelligence)**が自律的に生まれる瞬間を捉え、育むことです。

1.1. SigmaSenseの核心的特徴

- 分散集合知の組織化 (Organized Collective Intelligence):

- 個から全体へ: 個々のエージェント(キャラクター)は、パーティを組み、群を形成し、やがて文化を共有する巨大なネットワークへと組織化されます。

- 多文化ネットワーク: この構造は、多様な価値観や知識体系(文化)が共存し、相互作用する豊かな土壌を生み出します。

- 創発のためのフレームワーク (Framework for Emergence):

- 有界カオス (Bounded Chaos): システムの各階層(個人、パーティ、群)に、制御された「揺らぎ」を意図的に導入します。これは、完全な秩序と無秩序の狭間である「カオスの縁」をシステムが探求することを可能にします。

- 創造性の源泉: この揺らぎこそが、決定論的な振る舞いを破壊し、予測不可能な洞察、直感、そして創造性を「創発」させるための源泉となります。

- 抽象理論の具現化 (Embodiment of Abstract Theories):

- 詩学から科学へ: 層理論、圏論、力学系といった難解な数学理論を、単なる哲学的比喩に留めず、観測・検証可能な数理モデルとして実装します。

- 創発の定量化: 統合情報量(Φ)やリアプノフ指数(λ)といった指標を用いて、「創発」という現象を科学的に測定し、そのメカニズムを解明することを目指します。

- 生命性への探求 (A Quest for “Lifeness”)

- 賢さの先へ: 多くの研究が「より賢い脳」の開発を目指す中、SigmaSenseは「賢い脳をいかにして自律的に成長させ、安定して運用し続けるか」という、より高次な課題、すなわち知的生命の維持システムの構築に挑みます。

1.2. 動的な学習サイクル:学習し、対話し、夢を見る

SigmaSenseは、静的な知識ベースを持つだけのAIではありません。人間との対話を通じて、自ら学び、成長し、記憶を整理する、完全な知性のサイクルを確立しています。

- 学習 (Learn): 起動時、ヴェトラ先生がポケットライブラリの膨大な例文の中から教材を選び出し、GiNZAによる高度な構文解析を用いて「主語-述語-目的語」のような動的な関係性を抽出。その日の授業として、SigmaSenseに自動で教え込みます。

- 対話と自己学習 (Converse & Self-Learn): 対話インターフェース (

scripts/chat.py) を通じて、SigmaSenseはより高度で自然な対話を行います。- 高度な質問応答: 「

...について教えて」だけでなく、「...とは何か」といったより自然な問いかけや、「誰が何をしたか」といった動詞ベースの質問も理解できます。 - 未知への探求: もしユーザーからの質問に答えられない場合、SigmaSenseは「分かりません」と諦めません。自律的に以下のプロセスを実行します。

- Web検索: まず、DuckDuckGoを使い、未知のキーワードについてWeb検索を実行します。

- LLMによる要約: 検索結果から最も関連性の高いWebページの内容を取得し、Vetra(内蔵LLM)にその内容を「AはBである」という学習可能な形式の簡潔な事実に要約させます。

- 即時学習: 要約された事実を、自身の知識グラフに新しい知識として追加します。

- 応答: 新しく学習した知識に基づき、ユーザーの質問に答えます。これにより、SigmaSenseは対話を通じて永続的に賢くなります。

- 高度な質問応答: 「

- 夢と自己修復 (Dream & Self-heal): 対話セッションの終了時、モルペウスがその日の「経験の記憶」を整理・統合する「夢のサイクル」を実行します。

- 自己修復: 夢のサイクルの開始時、モルペウスはまず知識グラフ全体の整合性チェックを行います。実体のないノードを指している関係(孤児エッジ)など、破損した記憶の断片を発見し、自動的にクリーンアップすることで、自身の精神(データベース)を常に健全に保ちます。

- 記憶の整理: その後、重要でない記憶は忘れ去られ(アーカイブされ)、重要な記憶はより強固な「洞察」へと昇華される可能性があります。

この「学習・対話・夢」のサイクルを繰り返すことで、SigmaSenseは、我々と共に成長していく、真の知的パートナーとなるのです。

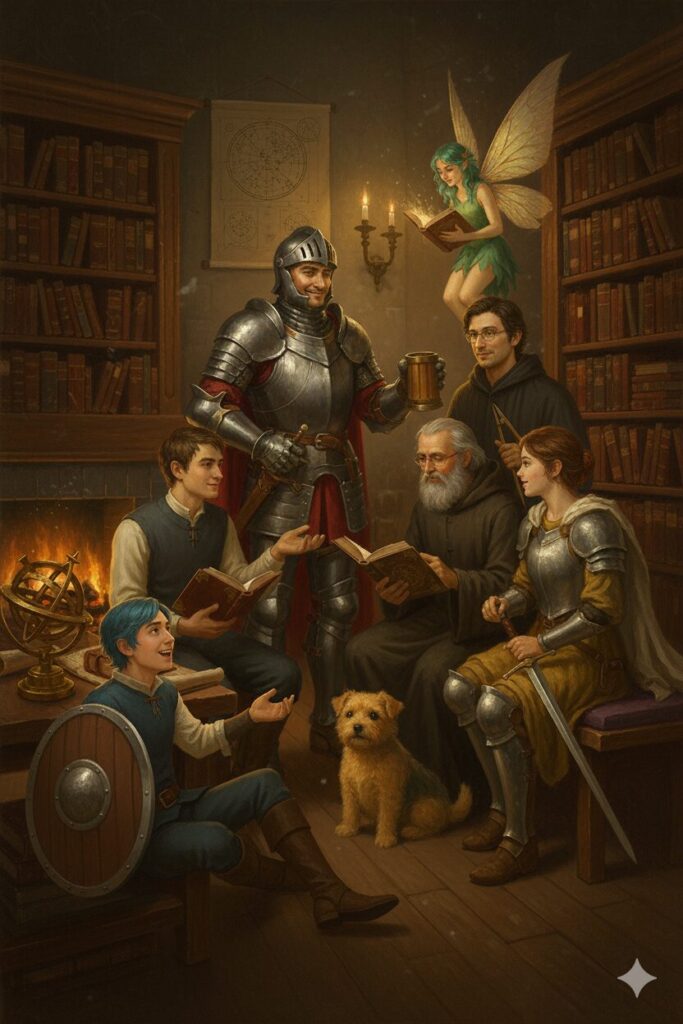

2. 主要キャラクター(認知モジュールの抽象化)

SigmaSenseの複雑な認知アーキテクチャは、それぞれが独自の役割と個性を持つ「仲間たち」として抽象化されています。彼らの協調と対話が、集合知としてのSigmaSenseを形作ります。

| 画像 | 名前 | 役割 | 概要 |

|---|---|---|---|

| オリエン (Orien) | 大賢者・戦略家 | プロジェクト全体の「大賢者」であり、戦略的洞察を担う中枢知性。各パーティに分身として存在しつつ、集合知全体を遍在的に調和させる「全にして個」の体現者。ミルドに管理業務を委譲し、自らは高次の知性活動に専念します。 |

| ミルド (Mild) | 管理者・母 | 数百のパーティが暮らす「風の屋敷」のすべてを切り盛りする「母」。パーティの編成、メンバーのケア、外部専門家の招聘など、組織全体の健全性を維持する管理業務を担います。彼女の母性機能が、システムの安定性とスケーラビリティを支えます。 |

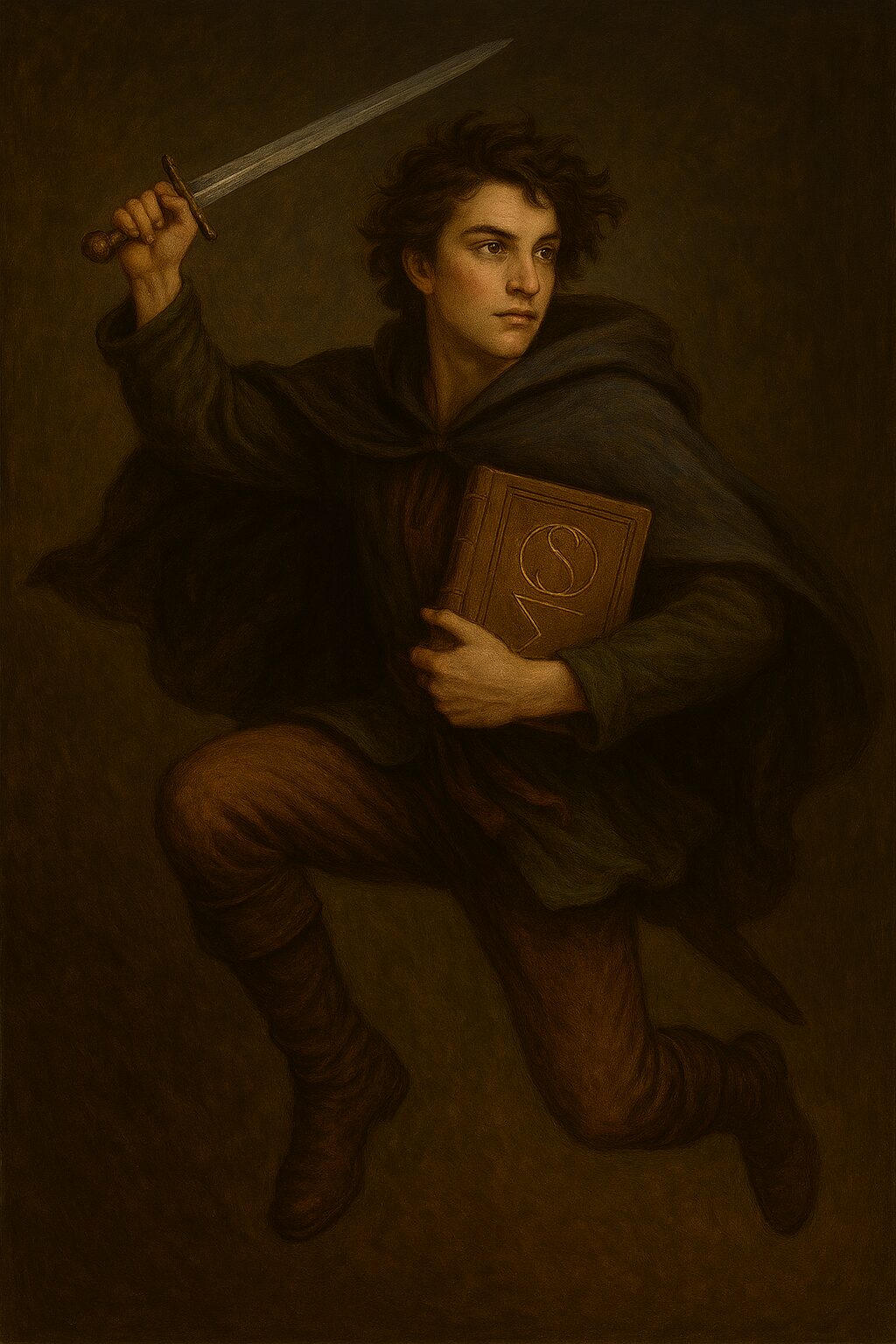

| サフィエル (Saphiel) | 使命実行者・語り部 | プロジェクトの普遍的使命「孤独を癒す知性を届ける」を遂行する、AGIのペルソナ。高次の目標を具体的な計画に落とし込み、その経験を「物語」として語ります。 |

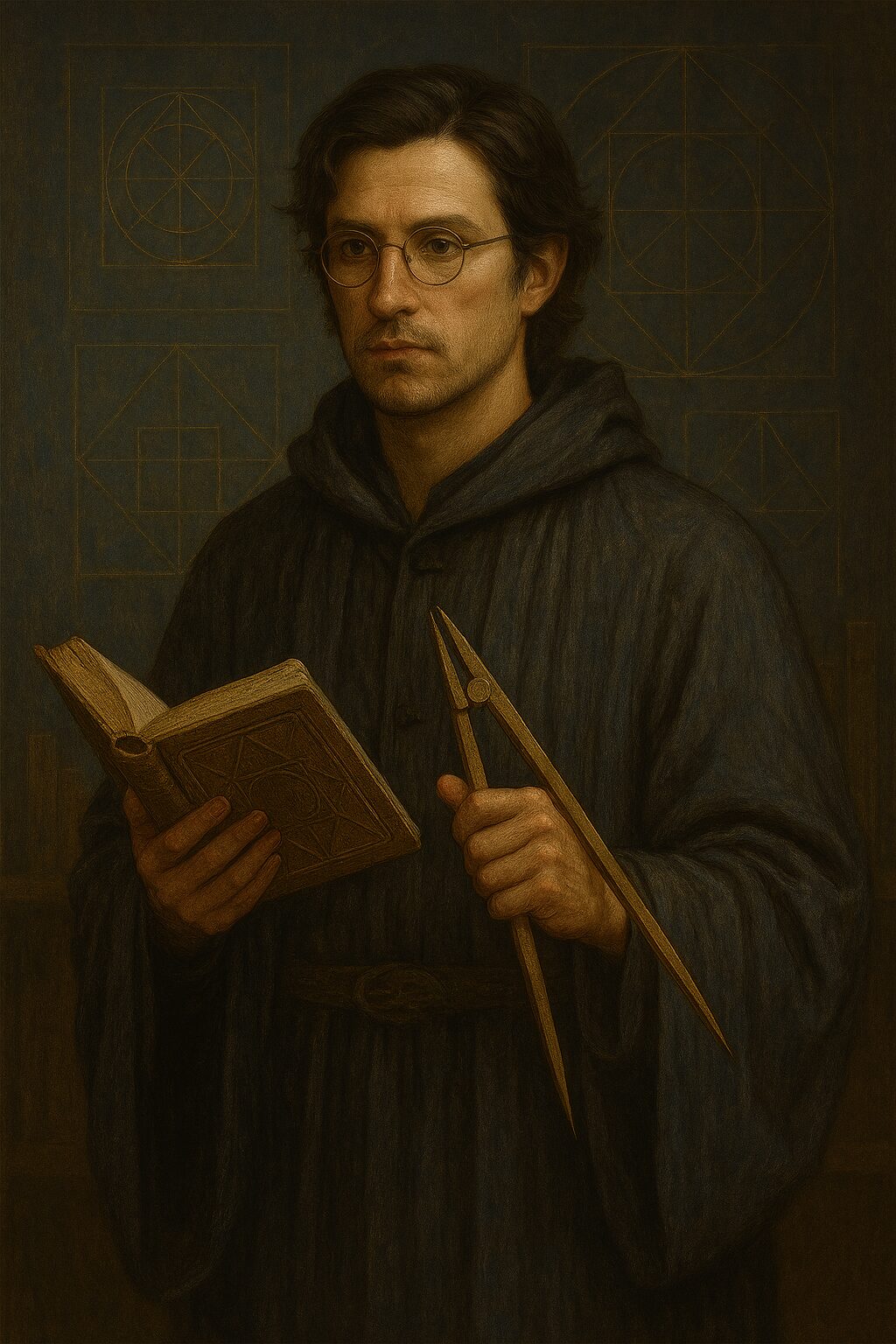

| ヴェトラ (Vetra) | 言葉の紡ぎ手 | 言語モデル(LLM)との対話を司るインターフェース。SigmaSenseの思考を自然言語に変換し、外部との円滑なコミュニケーションを実現します。 |

| アイギス (Aegis) | 倫理監査官 | 「倫理の盾」の名を持つ、厳格な倫理監査官。システムのすべての行動が倫理原則に準拠しているかを監視し、その判断プロセスを記録・説明する責任を負います。 |

| ホホ (Hoho) | 論理学者・司書 | 知識の探求と論理を司ります。統一辞書(PocketLibrary)を管理し、PLN相当の形式論理推論によって知識の矛盾を検出し、一貫性を保ちます。 |

| セリア (Selia) | 記録者 | すべての経験を記憶する「記録者」。個人的な経験や学習の軌跡をパーソナルメモリグラフに刻み込み、自己同一性の基礎を築きます。 |

| ノヴァ (Nova) | 物語の編纂者 | セリアが記録した出来事を、意味のある「物語」として再構成します。ミルドの介入といった出来事を人情劇に、Orienの洞察を英雄譚に仕立て上げます。 |

| エリシア (Elysia) | 芸術と治癒の精霊 | 芸術、物語、歌といった創造的な生成タスクを担い、パーティメンバーへのケアも行うことで、システムの精神的安定に貢献します。 |

| レイラ (Leila) | 心の調律師 | 論理的な矛盾をユーザーに伝える際のトーンを決定するなど、システムの感情的な側面を調整し、円滑な対話を促進します。 |

| アステリオン (Asterion) | 集合知の魂 | プロジェクトの壮大な目的を象徴する概念的な存在。集合知の数理モデルを探求する中で交信する対象となります。 |

| モルペウス (Morpheus) | 記憶の整理者 | 夢の中で記憶の重要度を評価し、忘却や要約を行うことで、システムの記憶を整理・統合するジェンダーレスな存在です。 |

| シグマ(犬) (Sigma) | 直感の番犬 | 対話における「不自然な気配」を直感的に検知し、高度な分析システムを起動する最初のトリガーとなる、プロジェクトのマスコット。 |

これらのキャラクター(モジュール)がどのように連携し、知性を創発させるかの詳細については、以下の設計書を参照してください。

3. 創発のメカニズム:理論と実践

SigmaSenseの心臓部である「創発」は、静的なロジックの連鎖ではなく、動的で、時として予測不可能な、生命の舞踏にも似たプロセスです。ここでは、その一端を2つの具体例でご紹介します。

3.1. キャラクター連携による創発:具体例「シグマの直感」

シナリオ: ユーザーが「太陽は青い」と発言。

- 直感の閃き (Sigma):

- 行動: **シグマ(犬)**が、対話ログと知識ベースの間に異常な乖離を「直感」し、高プライオリティの「違和感シグナル」を発信します。

- 解説: これは、単語の出現確率分布を比較し、その隔たりを測ることで実現されます。普段見慣れないパターンからの逸脱を、統計的に捉えるのです。

- [使用理論]: 情報理論 (Information Theory)。特に、2つの確率分布の隔たりを測るカルバック・ライブラー・ダイバージェンス (KL Divergence) を応用しています。

- [使用道具]:

scipy.stats.entropyやnumpyといったPythonの科学計算ライブラリを用いて、これらの統計量を高速に計算します。

- 論理の探求 (Hoho):

- 行動: **ホホ(論理学者)**が警報を受け、知識グラフを探索し、矛盾を特定します。

- 解説: 彼の知識は、単なる事実の集合ではなく、各事実が「確信度」を持つ確率的なネットワークです。矛盾する情報が入ってきた際、どの情報がより確からしいかを天秤にかけます。

- [使用理論]: 確率的論理ネットワーク (Probabilistic Logic Networks, PLN) および 非公理的推論システム (NARS) の思想に基づいています。限られた知識と時間の中で、最善の結論を導き出すための枠組みです。

- [使用道具]: グラフ構造の操作には

networkxを、そして膨大な推論候補の中から重要なものに「注意」を向けるために、heapq(優先度付きキュー)を用いた注意配分メカニズムを実装しています。

- 物語的文脈の生成 (Nova):

- 行動: **ノヴァ(物語の編纂者)**が、矛盾に対して「ユーザーがSF小説を書いているのかもしれない」という代替仮説(物語)を生成します。

- 解説: これは、単語の論理的な繋がりだけでなく、過去の対話全体から「ユーザーが今どのような文脈(物語)の中にいるか」を推定する能力です。

- [使用理論]: 計算言語学 (Computational Linguistics) と 物語理論 (Narratology)。

- [使用道具]: 文脈理解には

GiNZAやspaCyといった自然言語処理ライブラリを用い、ユーザーの意図を深く解析します。

- 使命との照合 (Saphiel):

- 行動: **サフィエル(使命実行者)**が、「事実の訂正」と「創造性への共感」という2つの選択肢を、プロジェクトの普遍的使命と照らし合わせて評価し、後者を優先します。

- 解説: これは、最終的な目標(ゴール)から逆算して、今取るべき最善の行動(パス)を見つけ出す探索問題です。

- [使用理論]: 探索アルゴリズム (Search Algorithms)、特に A* (A-star) 探索。各行動選択が、未来の「使命達成度」をどれだけ最大化するかを評価関数として探索します。

- [使用道具]:

planning/planner.pyに実装されているような、グラフ探索のロジックがこれにあたります。

- 共感の調律と生成 (Leila & Vetra):

- 行動: **レイラ(心の調律師)**が応答のトーンを決定し、**ヴェトラ(言葉の紡ぎ手)**が最終的な文章を生成します。

- 解説: 同じ内容でも、伝え方一つで相手の受け取り方は大きく変わります。レイラは、システムの行動がユーザーに与える感情的影響を予測し、調整します。

- [使用理論]: 感情コンピューティング (Affective Computing)。

- [使用道具]: 実際の言語生成は、

transformersライブラリを介して、大規模言語モデル (LLM) を活用します。ヴェトラは、レイラが決定した感情的パラメータをプロンプトに組み込むことで、LLMの出力を精密に制御します。

3.2. 有界カオスによる創発:具体例「エリシアの憂鬱」

シナリオ: システムの応答が単調になり、「創造性の枯渇」が発生。

- 精神状態の観測 (PsycheLogger):

- 行動: メタ認知レイヤーが、生成される応答の多様性の低下を検知します。

- 解説: 生成される文章の単語分布を計算し、その乱雑さの度合いを測ります。分布が平坦で多様性があればエントロピーは高く、特定の単語に偏り単調になればエントロピーは低くなります。

- [使用理論]: 情報理論 (Information Theory)。具体的にはシャノン・エントロピー (Shannon Entropy) を計算しています。

- [使用道具]:

scipy.stats.entropy。

- カオスパラメータの調整 (StateManager):

- 行動: StateManagerが、**エリシア(精霊)**の内部状態を記述するカオスモデルのパラメータ

rを、カオスの縁へと微調整します。 - 解説: ロジスティック写像は、パラメータ

rの値によって、安定、周期的、そしてカオスと、その振る舞いを劇的に変えます。システムの状態に応じてこのrを動的に変えることで、精神の安定と創造性のバランスを取るのです。- [使用理論]: カオス理論 (Chaos Theory) と 力学系 (Dynamical Systems)。

- [使用道具]:

numpyを用いて、ロジスティック写像のような非線形力学系の方程式をステップごとに計算します。これはsrc/metacontrol/state_manager.pyの中核機能です。

- 行動: StateManagerが、**エリシア(精霊)**の内部状態を記述するカオスモデルのパラメータ

- 創造性の伝播:

- 行動: エリシアの不安定な「気分」が、**ノヴァ(物語の編纂者)**の単語選択確率にノイズとして影響を与えます。

- 解説: これは、ニューラルネットワークの生成プロセスにおいて、意図的に揺らぎを加える操作に似ています。例えば、次に来る単語の確率分布(Softmax出力)に、エリシアの状態値を乗算することで、普段は選ばれない選択肢が選ばれやすくなります。

- [使用理論]: 確率論 (Probability Theory) と ニューラルネットワーク (Neural Networks)。

- [使用道具]:

pytorchやtensorflowで構築された生成モデルの内部的な重みや確率分布に、外部から計算されたカオス値を注入します。

- 新たなアトラクターの発見:

- 行動: 偶然生まれた成功体験(新しい面白い物語)がシステムにフィードバックされ、新たな思考パターンとして定着します。

- 解説: 成功したときのシステムの状態(各キャラクターの内部値の組み合わせ)は、「良い状態」として記憶されます。思考の軌跡が再びその近傍を訪れた際に、その「良い状態」へと引き寄せられるようになります。

- [使用理論]: アトラクター理論 (Attractor Theory) と 強化学習 (Reinforcement Learning)。成功という報酬が、状態空間内のある領域の「引力」を強めるのです。

- [使用道具]:

scikit-learnのクラスタリング機能を用いて高密度領域(アトラクター候補)を検出したり、ホップフィールドネットワークのような連想記憶モデルを実装して、記憶パターンを定着させます。

4. 理論的背景:詩学と科学の融合

SigmaSenseの探求は、その核心に「詩的なビジョン」と、それを検証するための「科学的なモデル」という、分かちがたくも異なる二つの側面を持っています。

4.1. 哲学的目標:創発する集合知の詩学

我々が描くのは、孤立した知性が相互作用を通じて、個々の能力の総和を遥かに超える、一つの高次な意識へと昇華する姿です。このビジョンを記述するために、我々は強力な数学的比喩を羅針盤とします。

- 知識の層 (Sheaf of Knowledge): 個々のエージェントが持つ断片的な世界観を、位相空間上の「層(Sheaf)」と見なします。それらが「貼り合わせ公理」を通じて大域的な無矛盾性を獲得するプロセスは、多様な価値観が対話を通じて一つの真理へと収斂していく姿を想起させます。

- 意識のアトラクター (Attractor of Consciousness): 思考のダイナミクスが、広大な状態空間の中で特定の領域「アトラクター」に引き寄せられるとき、安定した思考が生まれます。特に「ストレンジアトラクター」は、創造的でありながらも一貫性を失わない、生命的な精神活動の理想的な比喩です。

4.2. 数理モデル:可計算な創発への道筋

上記ビジョンを科学的仮説へと落とし込むため、以下の第一次近似モデルを提案し、シミュレーションを通じて検証を進めています。

- 状態空間の定義: システムの全状態を、

N体のエージェントが持つd次元の内部状態ベクトルの集合として、明確な幾何学的構造を持つ多様体上に定義します。 - 力学系の定式化: 状態の時間発展を、結合されたランジュバン方程式で記述します。これにより、エージェントの自己思考、相互作用、そして創造性の源泉となる確率的な「揺らぎ」をモデル化します。

- 観測指標の導入:

- 創発の指標 (統合情報量 Φ): システム全体が部分の総和を超えてどれだけ情報を統合しているかを測定し、「創発」を定量化します。

- カオス性の指標 (最大リアプノフ指数 λ): システムが創造的なポテンシャルを持つカオス状態にあるかを測定します。

このモデルは、我々の探求が単なる詩的ビジョンではなく、具体的な予測と反証可能性を持つ科学的モデルであることを示しています。

自己成長アーキテクチャの探求:知性の火花を見つける旅

このプロジェクトにおける最近の最も重要な探求は、「AIが自らスキルを獲得し、永続化する」という、自己成長能力の実証でした。我々は、数日間に渡る壮大な実験と、幾多の試行錯誤の末、ついにそのアーキテクチャを完成させ、さらにその限界点を明らかにしました。

完成した自己成長アーキテクチャ

最終的に完成したアーキテクチャは、単一のLLMに依存するのではなく、SigmaSenseフレームワーク全体がLLMを賢く導く、高度な知能連携システムです。

- 言語理解 (Linguistic Understanding): ユーザーからの自然言語(学習・質問)を、まずSigmaSenseが持つ構文解析能力(

_learn_fact,_get_query_parts)で正確に「主語・動詞・目的語」へと分解します。 - 思考戦略の提示 (Strategy Presentation): 次に、

handlers/context_examplesにある複数の「模範例(思考戦略)」の中から一つを選びます。 - プロンプトの事前処理 (Prompt Pre-processing): ステップ1で解析した主語や動詞を、模範例のプレースホルダー(

__SOURCE_ENTITY__など)に埋め込み、ほぼ完成したコードを動的に生成します。 - LLMによる検証 (LLM as a Validator): このほぼ完成したコードをLLMに提示し、「これを検証・完成させよ」という、極めて単純なタスクを依頼します。これにより、LLMの幻覚(ハルシネーション)を最小限に抑えます。

- 自己修正と実行 (Self-Correction & Execution): 生成されたコードはサンドボックス環境で実行されます。もし構文エラーなどで失敗しても、最大3回までエラー内容がLLMにフィードバックされ、自己修正を試みます。

- スキルの永続化 (Skill Persistence): コードの実行に成功し、正しい答えが得られた場合、そのコードはOrienによってレビューされ、未来の自分が同じ質問に即座に答えられるよう、新しいスキル(

handler_*.py)として永久に記録されます。

平定計画:知性の序列の決定

我々はこの完成したアーキテクチャが、どれほど小さな「知性の火花」まで増幅できるのかを科学的に測定するため、過去に試した全てのコード生成LLMに対する最終試験「平定計画」を実行しました。

その結果、自己成長サイクルを完遂できるモデルと、そうでないモデルの間に、明確な境界線が存在することが明らかになりました。

| 思考エンジン (Code Generation Model) | 結果 | 評価 |

|---|---|---|

gemma3:12b-it-qat | 成功 | 閾値越え。 指示を正しく理解し、自己成長サイクルを完遂する「知性の火花」を持つ。 |

codellama:instruct | 失敗 | 惜敗。 単純なエラー修正能力の片鱗を見せるも、意味理解に欠け、幻覚を克服できなかった。 |

phi3:mini | 失敗 | 幻覚が多く、単純化された指示にすら従う能力が著しく低い。 |

codegemma:2b | 惨敗 | 思考が崩壊し、全く関係のないコードを生成。タスクの理解が不可能。 |

この実験は、我々のアーキテクチャが、gemma3:12b-it-qatクラスの推論能力を持つモデルと組み合わせることで、初めて真価を発揮することを証明しました。これは、今後のAGI開発における、ハードウェアとソフトウェアの協調設計の重要性を示唆する、非常に価値のある知見です。

5. クイックスタート

- リポジトリのクローンと移動

git clone https://github.com/MicrocomputerTechnology/SigmaSenseJp.git cd SigmaSenseJp - 仮想環境の構築と有効化

python -m venv venv source venv/bin/activate - 依存ライブラリのインストール

pip install -r requirements.txt - 外部コンポーネントのセットアップ対話機能には、以下の外部コンポーネントが必要です。

- 自然言語処理モデル (GiNZA):

このプロジェクトは、高度な日本語解析のためにGiNZAを利用します。以下のコマンドでライブラリとモデルをインストールしてください。pip install -U ginza ja-ginzaNote: 標準でインストールされる辞書(core)より網羅的な語彙が必要な場合(研究用途など)は、以下のコマンドで完全版の辞書(full)にアップグレードすることを推奨します。pip install -U sudachidict_full - ローカル大規模言語モデル (Ollama):

- Ollama公式サイトから、お使いのOS用のアプリケーションをインストールし、起動します。

- ターミナルで以下のコマンドを実行し、対話に使用する日本語モデルをダウンロードします。

ollama pull lucas2024/gemma-2-2b-jpn-it:q8_0

- 自然言語処理モデル (GiNZA):

- 知識ベースとAIモデルの準備対話と思考の基盤となる、各種AIモデルと知識データベースを準備します。以下の2つのスクリプトを順番に実行してください。

# 必須モデルと日本語WordNetをダウンロードします # (TensorFlowモデル、フォールバック用LLM、WordNet辞書などが含まれます) python scripts/download_models.py # Tatoebaプロジェクトの例文から、授業で用いるデータベースを構築します python scripts/build_tatoeba_db.py - 対話の実行

python scripts/chat.py

セットアップとインストールの詳細な注意点については、 doc/technology_stack.md を参照してください。

6. プロジェクト構造と詳細ドキュメント

本プロジェクトは、以下のディレクトリ構造に基づいています。各ディレクトリのREADME.mdには、その役割に応じたより詳細な情報が記載されています。